Foresight Ventures: AI + Blockchain=?

从可行性上看,现在的基础设施能一定程度上支持一定规模的模型,但还有很多不确定因素。

原文作者: yihan

原文来源:Foresight Ventures

Overview

通过这篇文章你可以了解:

- 什么是on-chain AI?

- 为什么还没有链上AI?

- AI上链的动力;

- 技术路径;

- 我理解的on-chain AI价值;

- on-chain AI的应用场景和项目分析。

一、AI + blockchain = ?

开发者对基础设施建设的疯狂执着和各种rollup解决方案的更新迭代确实让原本落后的web3计算能力实现了突破,这也为AI上链提供了可能性,但你可能想说与其大费周章地实现链上AI,直接在链下运行模型似乎也能满足大部分需求,而事实上现在几乎所有的AI模型都是以黑盒、中心化的模式在运行,并且同样在各个领域创造了无法替代的价值。

1)先回到最基础的问题,什么是AI上链?

主流的理解是通过区块链让AI模型transparent + verifiable

再具体一点,AI上链意味着人工智能模型的complete verification,也就是说一个模型需要向全网(用户或验证者)公开以下三点:

- 模型架构;

- 模型参数和权重:公开参数和权重有时候会对产品安全性产生负面影响,因此,针对特定场景,比如风控模型,可以对weight做隐藏处理以确保安全性;

- 模型输入:在web3的场景里基本上是链上公开数据。

当满足以上条件时,整个模型执行的过程是具备确定性的且不再是黑盒操作,任何人都可以在链上对模型的输入和结果进行验证,从而防止模型拥有者或者相关权限人对模型进行操纵。

2)AI + blockchain的动力是什么?

2)AI + blockchain的动力是什么?

AI与blockchain结合的意义不在于替代中心化的Web2人工智能的运作模式,而是:

- 在不牺牲去中心化和trustless的基础上,为web3世界创造下一阶段的价值。目前的区块链就像是web2的早期阶段,还没有承接更广泛应用或者创造更大价值的能力。而只有在加入AI之后,dapp的想象力才能真正跳跃到下一阶段,这些链上应用才有可能更接近web2应用的水平,这种接近并不是从功能上做的更相似,而是通过发挥区块链的价值,从用户体验和可能性上做出提升。

- 为web2黑盒的AI运行模式提供一种透明的、trustless的解决方案。

想象一下web3的应用场景:

- 将推荐算法加入到NFT交易平台,基于用户喜好推荐相应NFT,提高转化;

- 在游戏中加入AI对手方,更透明、公平的游戏体验;

……

但是, 这些应用都是通过AI对已有的功能在效率或者用户体验上的进一步改善。

-有价值吗?有。

-价值大吗?取决于产品和场景。

AI能创在的价值从来都不仅是99到100的优化,真正让我兴奋的,是从0到1的全新应用,一些只有通过transparent + verifiable的链上模型才能实现的use case。不过这些“令人兴奋的”use case目前主要靠想象力,没有成熟的应用,先来开几个脑洞:

- 通过基于neural network的决策模型做crypto trading: 一种产品形态可能更像是copy trading的升级版本,甚至是一种全新的交易玩法。用户不再需要信任或调研其他experienced trader,而是对彻底公开透明的模型以及其performance下注。本质上AI根据对crypto未来价格的预测更快更果断地进行交易。然而没有链上AI自带的“trustless autonomy”,这样的下注对象或者标准根本是不存在的。用户/投资者可以透明地看到模型决策的原因、过程甚至未来上涨/下跌的精确概率;

- AI模型作为裁判: 一种产品可能是全新形态的预言机,通过AI模型对数据来源的准确性进行预测。用户不再需要信任validator,也不必担心节点作恶,预言机提供方甚至不需要设计复杂的节点网络和奖惩机制来实现去中心化。相应地,链上transparent + verifiable的AI已经足够满足验证链下data source置信度的任务。这种全新的产品形态在安全性、效率和成本上有机会形成碾压,去中心化的对象也由人跳跃到“trustless autonomy”的AI工具,无疑是更安全的。

- 基于大模型的组织管理/运作体系: DAO的治理本质上应该是高效、去中心化、公平的,而现在的现状却背道而驰,松散且臃肿,缺乏透明和公平性,链上AI的加入能提供非常契合的解决方案,将管理模式、效率提升到最高,将管理中系统性和人性的风险无限拉低。我们甚至可以去想象一种全新的web3项目的发展和运作模式,整个框架及未来发展方向和提案几乎不依赖开发团队或者DAO投票的方式来进行决策,相应的,基于大模型更庞大的数据获取量和远超人的计算能力去做决策。但这一切的前提也是模型上链,没有AI的“trustless autonomy”就不存在去中心化世界从人到工具的跃迁。

……

小结一下

基于链上AI的新的产品形态基本可以总结为将去中心化和trustless的主体从人变为AI工具,这也符合传统世界生产力的进化过程,最开始是在人这个主体上下功夫,不断升级提升人效,到后面通过智能工具替代人,在安全性和效率上颠覆原有的产品设计。

其中最关键的、也是以上一切的前提,是通过区块链实现AI的transparent + verifiable。

3)Web3的下一个阶段

3)Web3的下一个阶段

区块链作为一个现象级的技术创新,不可能仅仅停留在原始阶段。流量和经济模型很重要,但用户不会一直停留在追捧流量或花费大量资源做X to earn,web3也不会因此onboard下一波新用户。但有一件事的确定性是很强的:web3世界生产力和价值的革命一定来自AI的加入。

我觉得大致分成下面三个阶段

起始:零知识证明算法和硬件的更新迭代为链上AI的涌现第一次提供了可能性;(我们在这)

发展:不管是AI对已有应用的提升还是基于AI + blockchain的全新产品,都在将整个行业向前推进;

终局:AI + blockchain的最终走向是什么?

上面的讨论都是通过AI与区块链的结合bottom up地发掘应用场景,换个思路top down地看待AI + blockchain,AI会不会重溯区块链本身?AI + blockchain = 自适应的区块链

一些公链会率先融合链上AI,从公链的层面转变为一种自适应的,自身发展方向不再依赖项目基金会决策而是基于庞大数据进行决策、自动化水平远超传统区块链的形态,从而从当前多链繁荣的格局中脱颖而出。

在verifiable + transparent的AI加持下,blockchain的自调节体现在哪里,可以参考modulus lab提到的几个例子:

- 链上的交易市场可以去中心化地自动调节,比如基于链上公开数据实时、不需要trust assumption地调整稳定币的interest rate;

- 多模态学习可以让链上协议的交互通过生物特征识别完成,提供安全的KYC,并实现身份管理的完全去信任;

- 允许链上应用最大化地捕获链上数据带来的价值,支持定制化内容推荐等服务。

从另一个角度看,zkrollup不断迭代优化,但是始终缺乏一个真正只能在zk生态上跑的应用,ZKML恰好符合这一点,并且想象空间也足够大。ZK-rollup未来很可能作为AI进入web3的入口从而创造更大价值,两者互相成就。

二、实现方式和可行性

1)Web3能为AI提供什么?

基础设施和ZK无疑是web3最疯狂内卷的赛道,各种ZK项目在电路优化和算法升级上下足了功夫,不管是对多层网络的探索,或者是对模块化区块链以及data availability layer的开发,还是进一步将rollup做成定制化的服务,甚至硬件加速……这些尝试都在将区块链的可扩展性、成本、算力推向下一个阶段。

AI + blockchain听上去不错,但具体怎么个加法?

AI + blockchain听上去不错,但具体怎么个加法?

一种做法是通过ZK proof system。比如针对machine learning做一个定制化的电路,链下电路生成witness的过程就是模型执行的过程,对模型预测的过程生成proof(其中包括模型参数和input),任何人都可以在链上验证proof。

AI模型还是在高效的集群上执行,甚至搞点硬件加速进一步提升计算速度,在最大化利用算力的同时确保没有中心化的人或者机构可以从中篡改或干涉模型,也就是确保:

模型预测结果的确定性 = 可验证的(input + 模型架构 + 参数)

根据以上做法,可以进一步推断哪些infra对AI上链至关重要:

- ZKP system、rollup:Rollups扩张了我们对区块链计算能力的想象空间,把一堆transactions打包,甚至递归地生成proof of proof进一步降低成本。对于现在庞大的模型来说,提供可能性的第一步就是proof system和rollup;

- 硬件加速:ZK rollup提供了verifiable的基础,但proof的生成速度直接关系到模型的可用性和用户体验,等待几个小时去生成一个模型的proof显然是不work的,因此,通过FPGA进行硬件加速显然是一个很好的boost。

- 密码学:密码学是区块链的基础,而链上模型以及敏感数据同样需要保证隐私性。

补充:

大模型的基础是GPU,没有高并行的支持,大模型的效率将会非常低,也就无法运行。因此,对于一个链上的zk生态:

GPU友好 = AI友好

拿Starknet举例,Cario只能在CPU上跑,因此只能部署一些小的决策树模型,长期来看并不利好大模型的部署。

2)挑战:更强大的proof system

ZK Proof的生成速度和内存使用情况至关重要,一个关系到用户体验和可行性,一个关系到成本和天花板。

现在的zkp system够用吗?

够用,但不够好…

Modulus lab在文章“The Cost of Intelligence: Proving Machine Learning Inference with Zero-Knowledge”非常详细的分析了模型和算力的具体情况。有空可以读一读这篇ZKML届的”零号文献-paper0“:https://drive.google.com/file/d/1tylpowpaqcOhKQtYolPlqvx6R2Gv4IzE/view

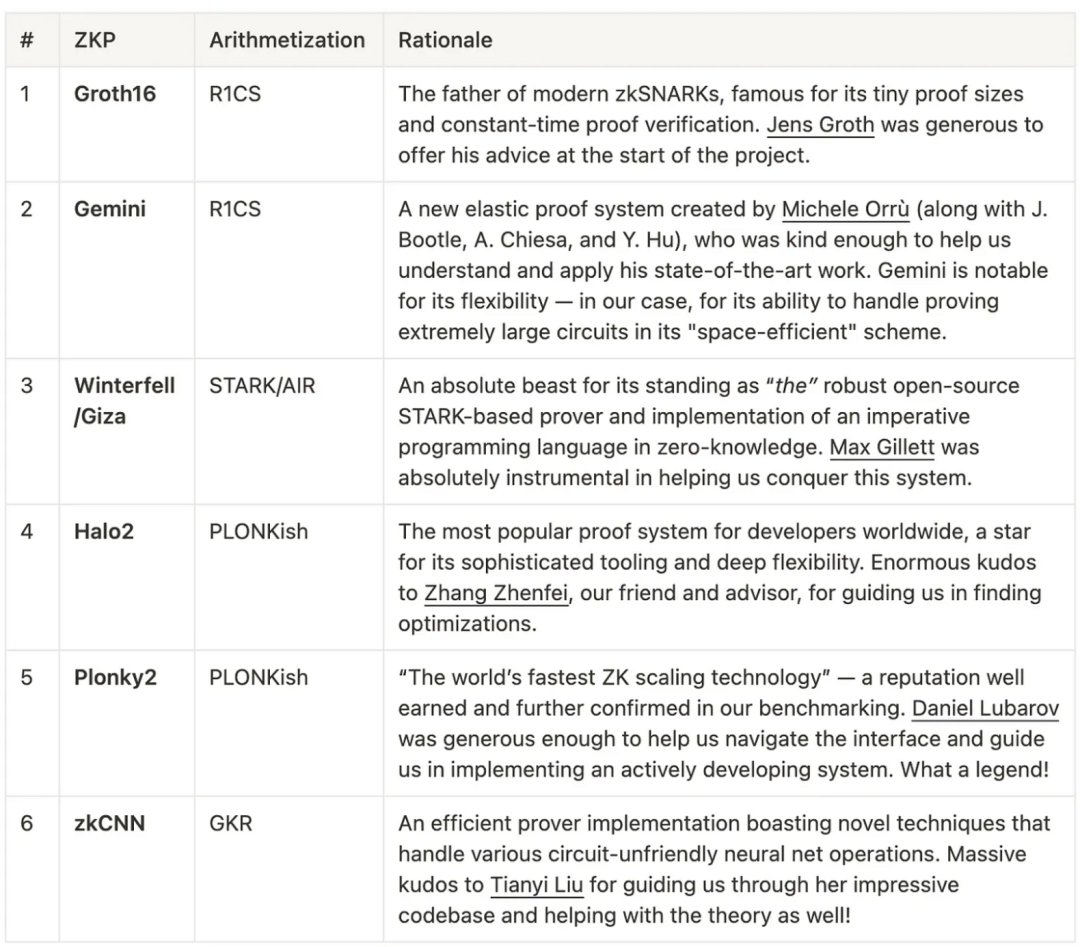

以下是paper0中提到的不同证明系统

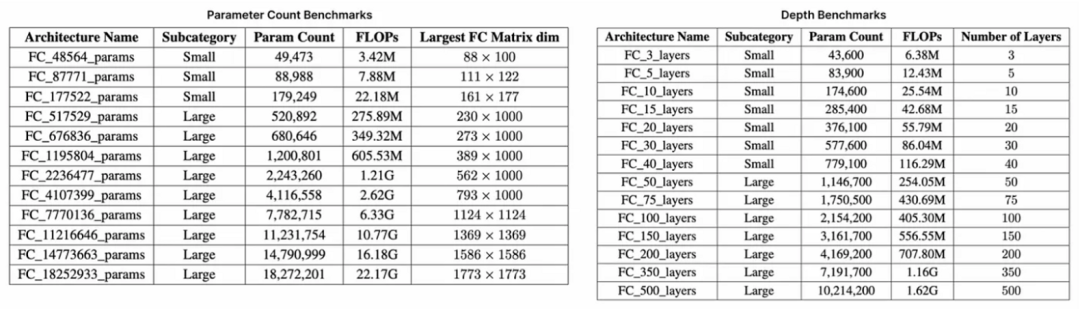

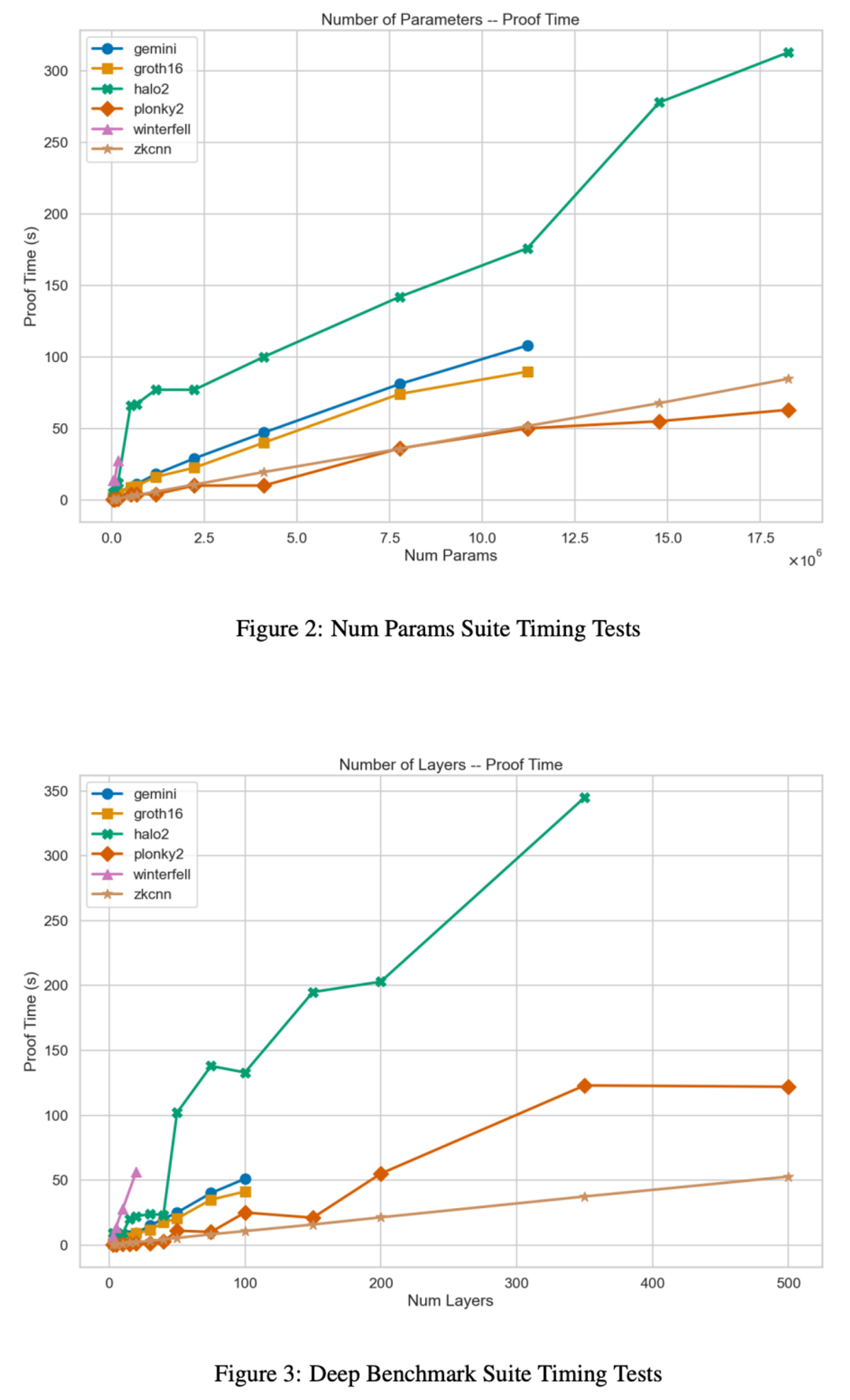

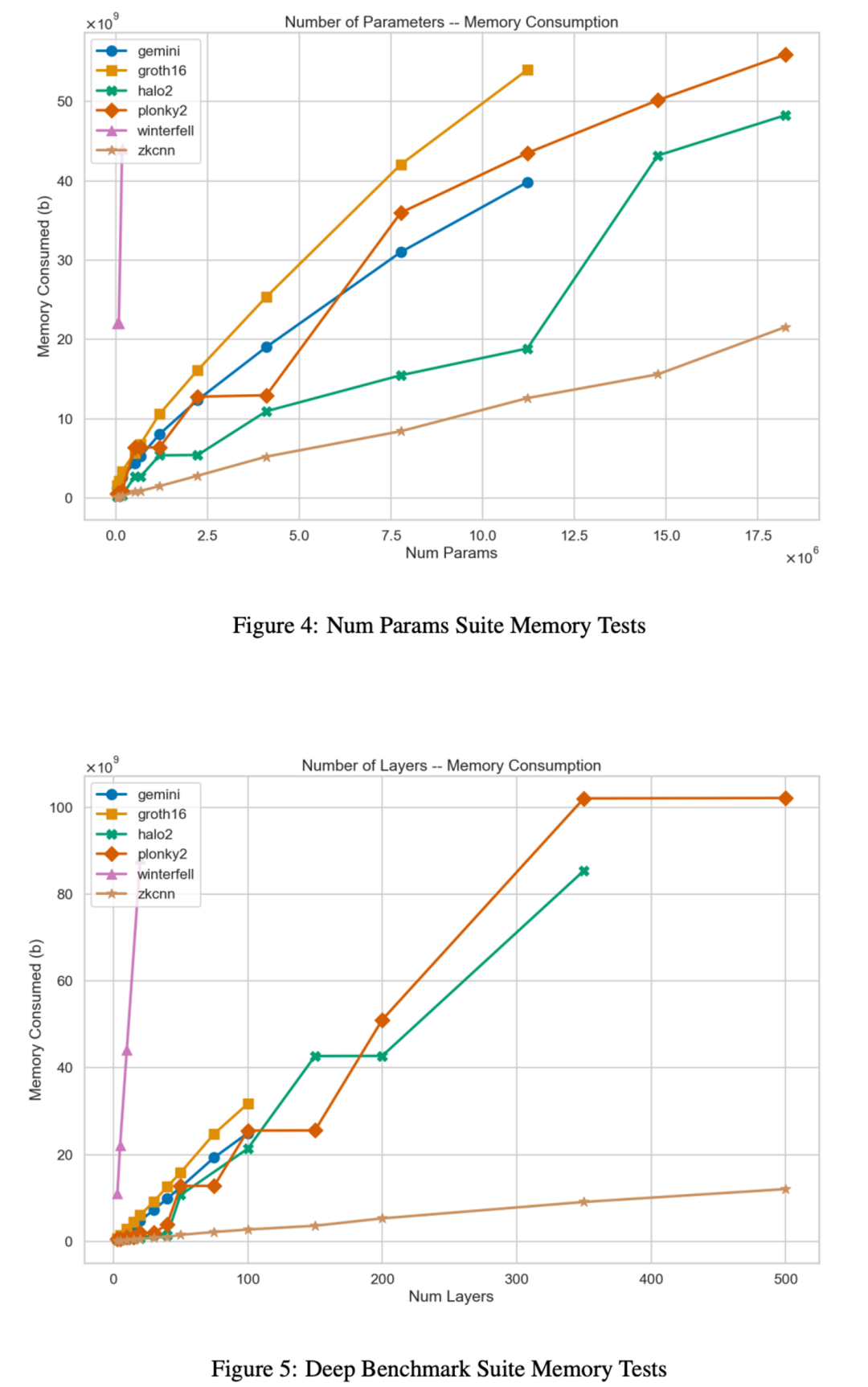

基于以上zk算法,modulus lab分别从时间消耗和内存占用两个维度出发进行测试,并且在这两个维度中分别控制了参数和层数两个核心变量。以下是benchmark suites,这样的设计也可以大致覆盖从LeNet5的60k参数量,0.5MFLOPs,到ResNet-34的22M参数量, 3.77 GFLOPs。

基于以上zk算法,modulus lab分别从时间消耗和内存占用两个维度出发进行测试,并且在这两个维度中分别控制了参数和层数两个核心变量。以下是benchmark suites,这样的设计也可以大致覆盖从LeNet5的60k参数量,0.5MFLOPs,到ResNet-34的22M参数量, 3.77 GFLOPs。

时间消耗的测试结果:

时间消耗的测试结果:

内存占用的测试结果:

内存占用的测试结果:

基于以上数据,整体看目前的zk算法以及具备支持对大模型生成proof的可能性,但相应的成本依旧很高,需要甚至10倍以上的优化。以Gloth16为例,虽然受益于高并发带来的computation time的优化,但是作为tradeoff内存占用显著增加。Plonky2和zkCNN在时间和空间上的表现同样验证了这一点。

基于以上数据,整体看目前的zk算法以及具备支持对大模型生成proof的可能性,但相应的成本依旧很高,需要甚至10倍以上的优化。以Gloth16为例,虽然受益于高并发带来的computation time的优化,但是作为tradeoff内存占用显著增加。Plonky2和zkCNN在时间和空间上的表现同样验证了这一点。

那么现在问题其实就从zkp system是否可以支持链上AI转变为了支持AI+Blockchain付出代价值不值? 并且随着模型参数的指数级上升,对proof system的压力也会迅速增加。确实,现在有trustless的神经网络吗,没有!就是因为成本算不过来。

因此,打造一个为AI定制化的proof system至关重要。同时,实现对AI这种单次调用计算十分复杂的逻辑,gas的消耗模型也需重新设计,一个高性能的zkvm至关重要,但现在我们已经能看到很多高性能的尝试,比如OlaVM, polygon Miden等,这些基础设施的不断优化极大提升了onchain-AI的可行性。

三、应用是否值得期待?

尽管链上AI还在很早期阶段,用上面的分层来看可能只处于起始到发展之间,但AI这个方向从不缺乏优秀的团队和创新的想法。

就像上面说的,从AI + Blockchain发展阶段看现在市场处于起始到发展的中间阶段,产品尝试方向还是以基于现有功能对用户体验优化为主。但最能体现价值的还是通过AI在链上将trustless的主体由人变为工具,在安全性和效率上颠覆原有的产品形态。

下面从一些现有的应用尝试出发,分析一下AI + Blockchain长期的产品发展方向

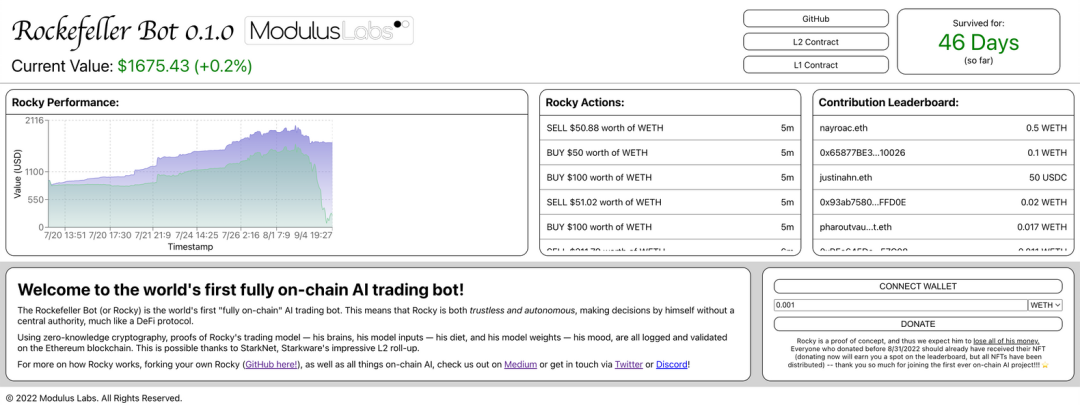

1)The Rockefeller Bot:世界上第一个on-chain AI

Rockefeller是modulus lab团队推出的第一个链上AI的产品,有很强的“纪念价值”。这个模型本质上是一个trading bot,具体来说,rockefeller的训练数据是大量链上公开的WEth-USDC的price/exchange rate,其本身是一个三层前馈经网络模型,预测目标是未来WEth价格涨跌。

以下是当trading bot决策要进行交易时的流程:

- Rockefeller在ZK-rollup上对预测结果生成ZKP;

- ZKP在L1上被验证(资金由L1的合约保管),并执行操作;

可以看出trading bot的预测、资金操作完全是去中心化且trustless的,就像上面提到的,从更高维度看rockefeller更像是一种全新的Defi玩法。相比于信任其他trader,这种模式下其实用户赌的是transparent + verifiable + autonomous的模型。用户可以不需要信任中心化的机构确保模型决策过程的合法性。同时,AI也能最大程度上的消除人性的影响,更果断地进行交易。

你可能已经想给Rockefeller注点资金玩一玩了,但这真的能赚钱吗?

你可能已经想给Rockefeller注点资金玩一玩了,但这真的能赚钱吗?

并不能, 按照modulus团队的说法,与其说rockefeller是一个应用,他更像是on-chain AI的POC,由于成本、效率、证明系统等多方面的限制,rockefeller的主要目的是作为一个demo让web3世界看到on-chain AI的可行性。(Rockefeller已经完成任务下线T T)

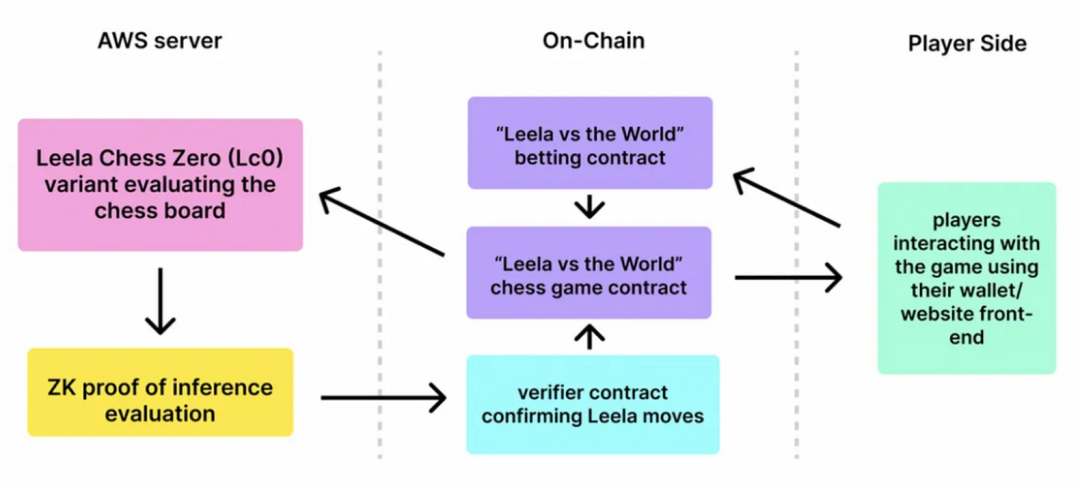

2)Leela:世界上第一个on-chain AI game

最近发布的Leela v.s. the world同样是出自modulus lab。游戏机制很简单,人类玩家组成阵营对战AI。游戏中玩家可以质押下注,最终谁会赢得对局,每次match结束后loser’s pool会根据质押代币的数量相应地分配给winner。

说到on-chain AI,这次modulus lab部署了一个更大的deep neural network(Parameter数量 > 3,700,000)。虽然在模型规模和产品内容上Leela都超越了rockefeller,但归根结底这还是一次大型的on-chain AI experiment。Leela的背后的机制和运行模式才是需要关注的,这能帮我们更好地理解链上AI的运行模式和改善空间,以下是官方给出的逻辑图:

说到on-chain AI,这次modulus lab部署了一个更大的deep neural network(Parameter数量 > 3,700,000)。虽然在模型规模和产品内容上Leela都超越了rockefeller,但归根结底这还是一次大型的on-chain AI experiment。Leela的背后的机制和运行模式才是需要关注的,这能帮我们更好地理解链上AI的运行模式和改善空间,以下是官方给出的逻辑图:

Leela的每一次move,也就是每次预测,都会生成ZKP,并且只有在经过合约验证之后才会在游戏内生效。也就是说,受益于trustless autonomous AI,用户下注的资金和公平性完全受到密码学的保护还不需要信任游戏开发者。

Leela的每一次move,也就是每次预测,都会生成ZKP,并且只有在经过合约验证之后才会在游戏内生效。也就是说,受益于trustless autonomous AI,用户下注的资金和公平性完全受到密码学的保护还不需要信任游戏开发者。

Leela采用的是Halo2算法,主要原因是它的工具和设计的灵活性可以帮助设计更高效的证明体系,具体performance情况可以参考上面的测试数据。但同时在Leela的运行中modulus团队也发现了Halo2的弊端,比如生成证明的速度较慢,对one-shot proving不友好等。因此,也更加印证了之前基于测试数据得出的结论:如果需要将更大的模型带入web3,我们需要开发更强大的proof system。

不过Leela的价值在于给我们带来了AI + Web3 game更大的想象空间,王者荣耀玩家此刻应该无比希望王者匹配算法fully on-chain:) Gamefi需要更优质的内容支撑和更公平的游戏体系,而on-chain AI恰好提供了这一点。打个比方,在游戏中加入AI-driven的游戏场景或者NPC,不管是玩家的游戏体验还是经济体系的玩法都提供了巨大的想象空间。

3)Worldcoin:AI + KYC

Worldcoin是一个链上身份体系(Privacy-Preserving Proof-of-Personhood Protocol),通过生物识别建立身份体系并实现支付等衍生功能,解决的问题是对抗女巫攻击,现在的注册用户超过了1.4m。

用户通过一个叫Orb的硬件扫描虹膜,将个人信息添加到数据库中,Worldcoin通过Orb硬件中的计算环境运行CNN模型压缩并证实用户虹膜数据的有效性。听上去很强,但如果需要做到身份验证的真正去中心化,worldcoin团队正在探索通过ZKP验证模型的输出。

用户通过一个叫Orb的硬件扫描虹膜,将个人信息添加到数据库中,Worldcoin通过Orb硬件中的计算环境运行CNN模型压缩并证实用户虹膜数据的有效性。听上去很强,但如果需要做到身份验证的真正去中心化,worldcoin团队正在探索通过ZKP验证模型的输出。

挑战

值得一提的是,worldcoin的CNN模型的size:参数=1.8 million,层数=50。基于上面展示的测试数据,现有的proof system在时间上完全可以胜任,但内存消耗对于消费级的硬件来说是不可能完成的。

4)其他项目

- Pragma:Pargma是从starkware生态上发展起来的ZK oracle。同时团队也在探索如何通过链上AI解决去中心化链下数据验证的问题。用户不再需要信任validator,而是通过足够精准且可验证的链上AI完成验证链下data source的工作,比如对于实际资产或者身份的验证可以直接让AI去读取相印的物理信息作为输入并做出决策。

- Lyra finance: Lyra finance是一个option AMM,提供衍生品交易市场。为了提高资本利用率,Lyra团队和modulus lab正在合作开发基于可验证AI模型的AMM。基于可验证的、公平的AI模型,Lyra finance有机会成为AI + Blockchain的一次大规模落地实验,为web3用户首次带来公平的matchmaking,通过AI对链上市场进行优化,提供更高的回报。

- Giza: ZKML平台,将模型直接部署在链上而不是进行链下验证,Nice try,but… 由于算力以及Cairo不支持CUDA-based的证明生成的问题,Giza只能支持一些小模型的部署。这也是最致命的问题,从长期来看,能对web3产生颠覆性影响的一定是大模型,而这种规模的模型必须有强大的硬件支持,比如GPU。

- Zama-ai:模型的同态加密。同态加密是一种加密形式,简单表示为:f[E(x)] = E[f(x)],其中f是运算操作,E代表同态加密算法,x是变量,比如:E(a) + E(b) = E(a + b)。允许对密文进行特定形式的代数运算得到仍然是加密的结果,将其解密所得到的结果与对明文进行同样的运算结果一样。模型的隐私性一直是AI + Blockchain方向的热点和瓶颈,虽然zk对隐私友好,但zk不等于privacy。zama致力于确保模型执行的privacy-preserving。

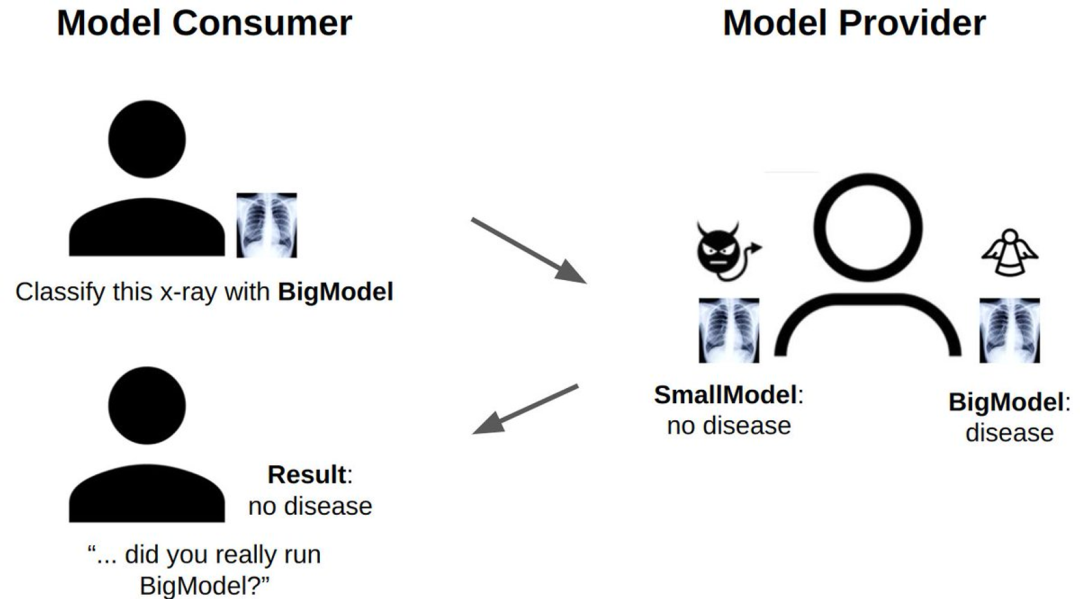

- ML-as-a-service: 这目前还只是一个思考方向,没有具体的落地应用,但目的是通过ZKP解决中心化ML服务提供者作恶以及用户信任的问题。Daniel Kang在文章“Trustless Verification of Machine Learning”中有详细的描述(参考文中的一张图)

四、关于AI + Blockchain的总结

四、关于AI + Blockchain的总结

- 整体来说,在web3世界里的AI处于非常早期的阶段,但是毋庸置疑的是onchain-AI的成熟和普及一定会把web3的价值带到另一个高度。从技术上看,区块链能给AI提供独特的基础设施,AI也是改变web3生产关系的重要工具,两者的结合可以碰撞出很多可能性,这也是值得兴奋和打开想象力的地方。

- 从AI上链的动力看,一方面,transparent + verifiable的链上AI将去中心化和trustless的主体从人变为AI工具,极大提升了效率、安全性,并且为创造全新的产品形态提供了可能性;另一方面,区块链的基础设施不断迭代,web3真正需要一个能让这些基础设施发挥最大价值的杀手级应用,ZKML恰好符合这一点,比如ZK-rollup未来很可能作为AI进入web3的入口。

- 从可行性上看,现在的基础设施能一定程度上支持一定规模的模型,但还有很多不确定因素。通过ZKP做可验证模型目前看是AI上链的必经之路,可能也是确定性最强的将AI带入的web3应用的技术路径。但是长远来看现在的proof system需要再进行指数级的提升才能足够支持日渐庞大的模型。

- 从应用场景看,AI几乎可以完美地参与到任何一个web3的方向,不管是game、Defi、DID、tooling…… 虽然目前已有的项目非常匮乏而且缺乏长期价值,还没有从一种提升效率的工具转变为改变生产关系的应用。但值得兴奋的是有人迈出了第一步,我们可以看到AI + blockchain的最早期的样子和之后的可能性。

Reference

- https://worldcoin.org/blog/engineering/intro-to-zkml

- https://medium.com/coinmonks/chapter-1-how-to-put-your-ai-on-chain-8af2db013c6b

- https://medium.com/@ModulusLabs/chapter-2-why-put-your-ai-on-chain-33b7625147b7

- https://medium.com/@ModulusLabs/chapter-3-the-worlds-first-on-chain-ai-trading-bot-c387afe8316c

- https://medium.com/@ModulusLabs/chapter-4-blockchains-that-self-improve-e9716c041f36

- https://medium.com/@ModulusLabs/chapter-4-5-trustless-ai-for-living-breathing-games-cc9f24080e30

- https://medium.com/@ModulusLabs/chapter-5-the-cost-of-intelligence-da26dbf93307

- https://medium.com/@ModulusLabs/chapter-6-leela-vs-the-world-the-worlds-1st-on-chain-ai-game-17ea299a06b6

- https://drive.google.com/file/d/1tylpowpaqcOhKQtYolPlqvx6R2Gv4IzE/view

- https://medium.com/@danieldkang/trustless-verification-of-machine-learning-6f648fd8ba88