苹果公司(Apple)加入大模型战争

大语言模型会给苹果带来新的增长点吗?

原文作者:阿法兔

原文来源:阿法兔研究笔记

根据科技媒体The Information的报道,在目前生成式AI爆火的4年前,苹果公司就成立了团队,专门开发大语言模型。不过,根据8月初苹果的财报,营收连续第三个季度下降,也是苹果自2016年以来最持久的财报表现下滑,主要是iPhone消费设备需求的下降,因为苹果利润的主要驱动力很大一部分来自于iPhone,那么,大语言模型会给苹果带来新的增长点吗?

据报道he内部消息,目前苹果的大模型团队只有 16 人,但苹果每天给大模型团队的预算高达数百万美元。The Verge提到,苹果的生成式AI由John Giannandrea掌舵,也有消息说 Giannandrea对人工智能语言模型驱动的聊天机器人的潜在应用场景,表示怀疑。

苹果的其他团队也在参与人工智能的研究,某个视觉智能部门正在开发图像生成模型,还有其他小组正在参与多模态研究。

苹果正在开发新的聊天机器人,将“与使用AppleCare的客户互动。还有用来优化Siri使用场景的。

观察苹果公司人工智能领域的人才,也是目前看来,优势不一定明显,但是苹果在移动设备的优势一骑绝尘,全球活跃的苹果设备超20亿,并且,苹果也有计划在 Siri 中集成语言模型,让用户通过语音指令自动完成复杂的任务(人机交互界面的创新)。

苹果在数据保护和隐私领域的能力也相对强,随着大模型的进一步普及,运行成本越来越低,移动设备究竟有没有可能运行(大)语言模型?

人工人脸识别AI模型完全在 iPhone 上运行,而不是在服务器上,会从某种层面上降低人们对人工智能数据隐私的担忧。

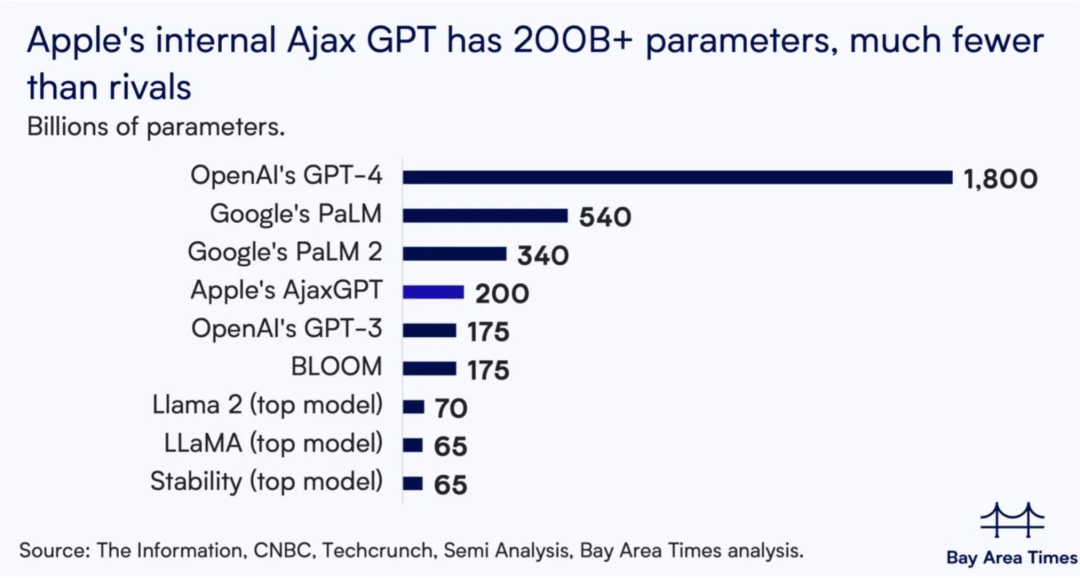

现在苹果公司的 Ajax GPT(2000 亿+参数)需要大量的计算和内存,无法在移动设备上运行,但很多开发人员已经在手机和笔记本电脑上运行了现有模型的小版本——谷歌 PaLM 2 和 Meta Platforms 的 Llama 2,等等。(下图为苹果的Ajax GPT的表现)

2023年9月4日,苹果团队发布了名为《 One Wide Feedforward is All You Need 》的论文(见下图)。

2023年9月4日,苹果团队发布了名为《 One Wide Feedforward is All You Need 》的论文(见下图)。

在这篇论文中,苹果团队研究了FNN——前馈神经网络(Feedforward Neural Network)在Transformer模型中的重要性,分析了跨层共享 FFN 的影响。然后发现,FFN 组件的冗余性,对Transformer模型的影响非常大。

在这篇论文中,苹果团队研究了FNN——前馈神经网络(Feedforward Neural Network)在Transformer模型中的重要性,分析了跨层共享 FFN 的影响。然后发现,FFN 组件的冗余性,对Transformer模型的影响非常大。

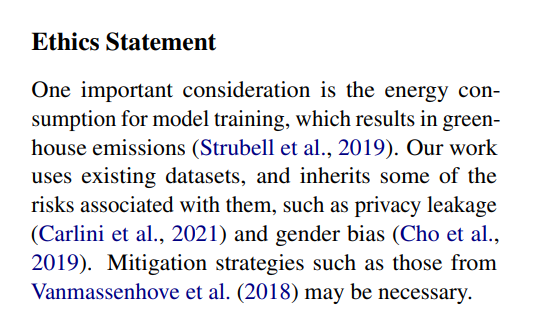

并且这篇论文在结尾进行了伦理声明,对模型训练的能耗进行了考量,提到了防止隐私泄露的必要性。

基于苹果在移动设备和PC上的市场占有率,如果苹果公司的开发人员能够让更小版本的 Ajax GPT 在 iPhone 和 Macbook 上完全运行,就能满足很多移动用户在终端设备的需求。

基于苹果在移动设备和PC上的市场占有率,如果苹果公司的开发人员能够让更小版本的 Ajax GPT 在 iPhone 和 Macbook 上完全运行,就能满足很多移动用户在终端设备的需求。

除此之外,苹果人工智能团队有不少前谷歌人工智能的研究员,因此,苹果会更偏爱谷歌的云服务和TPU。例如,苹果的模型训练软件针对 TPU 进行了优化(Optimized for TPUs)。

但是,如果苹果对语言模型的使用(因此对 TPU 的需求)出现爆炸式增长,在谷歌在与亚马逊(AWS)和微软(Microsoft)等其他云服务商竞争时,苹果会获得新的增长动力吗?