解读Chainbase:最大的全链数据网络,让 Crypto 与 AI 互相成就

Chainbase 旨在将所有区块链数据整合到统一的生态系统中,成为 AGI 时代最大的可信的、稳定的、透明的数据源。

撰文:深潮 TechFlow

眼下的加密市场,逐渐进入整理期。当叙事沉寂、存量项目们乏善可陈时,新的 Alpha 机会在哪里?

向外看,AGI时代浪潮已至;向内求,AI 仍是贯穿全年的加密叙事,也是吸引注意力和流动性的香饽饽。

只不过,现在你需要在 AI 赛道中,更加细致的去寻找 “结构性”机会:

围绕 AI 的三个基本要素:算力、算法和数据,前两者已经跑出了如 Render Network 、IO 和 Bittensor 等头部项目,且类似项目扎堆已成红海;而数据类项目,更多朝着 DePIN 发展。

真正将 Web3 原生链上数据有效利用的方向,仍是发掘 Alpha 的宝地。

而一级市场嗅觉灵敏的资金们,早已开始用脚投票:

最近重量级融资再现。数据赛道项目 Chainbase 宣布完成 1500 万美金 A 轮融资,Matrix Partners 领投,并得到某互联网公司战略投资、Hash Global、Folius Ventures、JSquare、DFG、MaskNetwork、Bodl Ventures、Bonfire Union Ventures 等知名机构共同参与。

资金的流向在一定程度上意味着对叙事的预判和项目的看好,那么, Chainbase 为何受到资金青睐?

TLDR : 最大的全链数据网络,一种开放的数据堆栈技术

这里有一些太长不看版的关键亮点,助你快速了解 Chainbase。

更高维度的产品:谈起链上数据,惯性印象是与聪明钱分析、看板构建、数据查询...Chainbase是一个在更高维度的 Infra(基础设施)产品,这些应用都能通过它实现,但 Infra 能做的远不止这些。

最大的全链数据网络:这个更高维度的坐标轴,始于其最大的"全链数据网络" --- 将整个广阔、碎片化的加密世界任何链中的任何数据,甚至是链下数据进行汇集与加工,成为一座价值亟待开采的数据金矿;

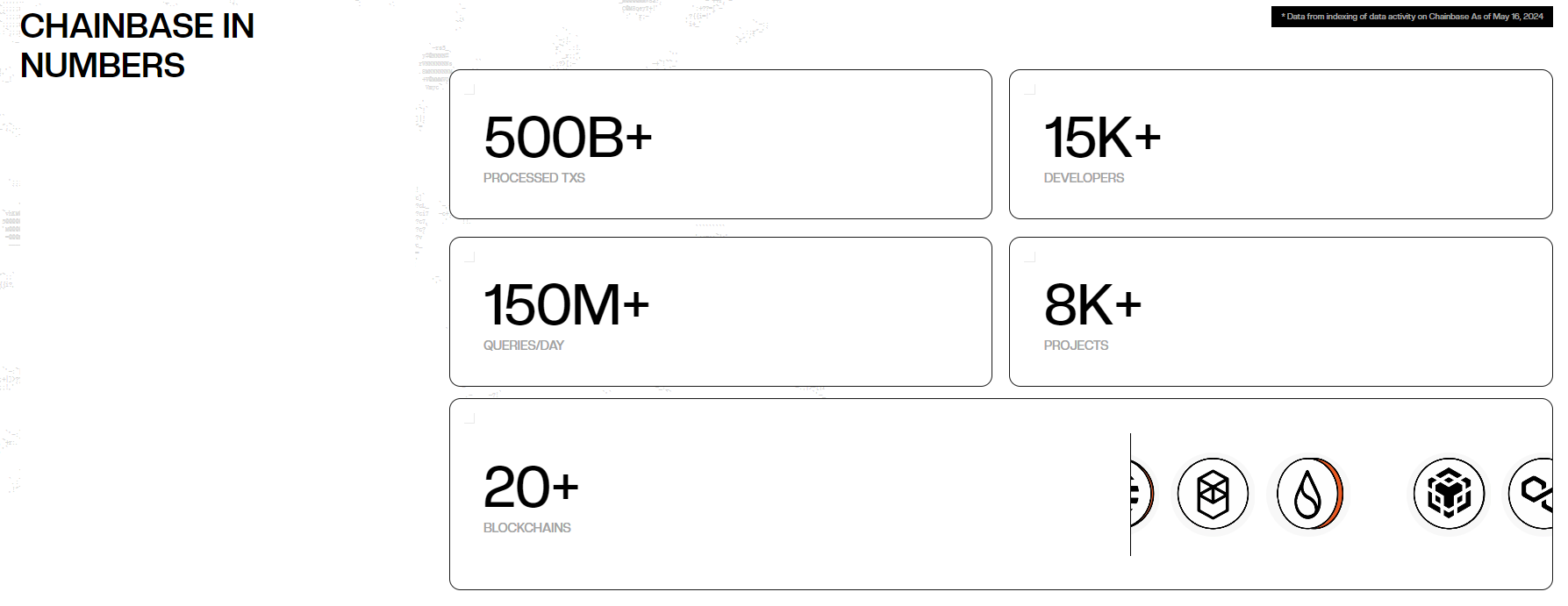

扎实的项目背景/团队/背书:Chainbase 吸纳了15000+开发者和8000+项目,处理着 5000亿次的全链数据调用,团队成员来自顶尖科技公司数据相关专业领域,且除了上述参投资方外,产品架构上到了顶级合作方支持(Eigenlayer 提供经济安全,Cosmos 提供共识安全)

自洽的数据网络实现逻辑:和"先有链再有应用场景"的公链发展方式不同,Chainbase 一开始就瞄准技术开发者以及普通用户,提供高质量数据;在生态和用例成熟后构建自己的数据网络。

Crypto Natvie 的 AI 大语言模型:和业内绝大多数套壳gpt的项目不同,Chainbase 自研的 Theia AI 模型,利用原生的高质量onchain数据进行训练,且可兼容多模态交互,有成为 Web3 X AI 全景奠基石的潜力。

当所有的链上下数据都能够被贡献并发挥自己应有的价值,当所有的人都可以通过数据+AI找到适合自己的使用场景时;

Web3 开始有了自己的 On-Chain Data Infra。 这个市场的想象力变得巨大,Alpha 的气息呼之欲出。

正如预言机之于DeFi,数据之于 AI,当全链数据跳起"智能之舞",加密舞台是否会上演一出新的好戏?

拿好早鸟票,我们带你进行一次“提前探班”:对 Chainbase 这个最大的全链数据网络的产品机制、适用场景、AI能力和经济模型,进行抢先解读。

链上数据,尚未高效利用的"暗知识"

想要搞懂 Chainbase,理解其业务逻辑,首先需要明白数据的价值。

早在2017年,《经济学人》的封面文章提到,“数据已经取代石油,成为新时代世界最有价值的资源”。而当时间来到24年,随着AGI(通用人工智能)趋势的崛起,数据这个最有价值的资源,已然进一步被 AI 高效开采与利用:

OpenAI 从 45TB 的原始数据中提取570G数据来训练 GPT3,海量,迅速,实时,且成体系,更不用说GPT4;数据质量和数量都在不断扩张,为 AI 的上佳表现创造条件。

与之相比,加密世界中的链上数据,仍未得到高效的利用。

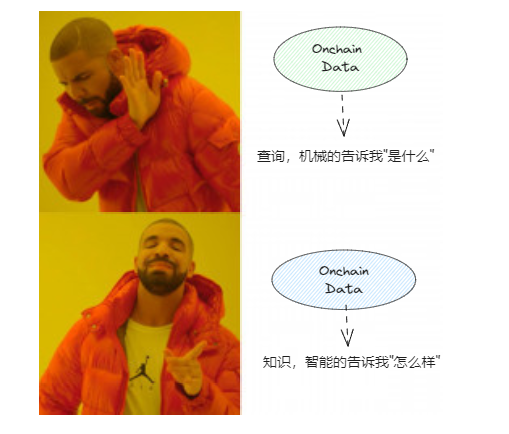

如今 Web3 里的数据更像是在不同的角落里躺着。大部分加密项目,所做的无非是让躺着的数据站起来 --- 比如通过传统的数据库模式,利用索引查询链上数据;又或者是通过 Text to SQL 的方式,将传讯需求变成一段 SQL 代码并呈现查询结果...

你用到的链上数据,既没有被智能的分析,也不能做到实时反馈,更无法遍历加密世界所有链的所有角落,成体系的像 GPT 那样给你输出知识与智慧。

我们只能用链上数据客观机械的回答"是什么",但智能化的"怎么做"仍没有答案;换言之,链上数据看起来明牌可见,但实则仍是沉睡的"暗知识"。

不够智能,不够主动,不够有创造性,更不够去中心化。

多数加密项目在利用数据时,社区的能动性却没有得到最大程度的发挥。

加密玩家们藏龙卧虎,本可以从自身投研需求出发自己打样,告诉大家怎样的场景应该怎样利用数据,但目前看这种去中心化的"知识共建",仍不够普遍。

此外,链上数据从整理到加工,从输出到利用,整个流程中也很难有社区参与的空间,怎么最大化调动加密生态中不同参与者的积极性,去构建一个更大的数据网络,仍是一个有吸引力且应该被实现的议题。

因此,我们需要高效的利用链上数据,更需要以去中心化的方式去利用数据:

从 SQL查询、索引式、非实时的利用方式”升维“,变得更加智能化;

从 OpenAI 那样的集权集中, 变得更加透明、可信、开源与社区共建。

而这,也是 Chainbase 登台表演的时刻。

万链归一,全链数据的登台之路

从以上背景出发,你就更容易理解 Chainbase :

构建世界上最大的全链数据网络,旨在将所有区块链数据整合到统一的生态系统中,成为 AGI 时代最大的可信的、稳定的、透明的数据源。

一个更容易理解的描述是,任何链上的任何数据,都可以为任何人更加智能化的利用。

如果你一时半会无法理解"全链数据网络",不妨先对全链数据拿起显微镜观察。

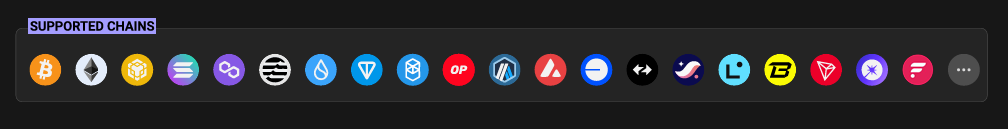

首先,全链数据到底有多"全"?

每个链都有自己的架构和数据,Chainbase 更像一种万链归一,将 BTC、ETH等几十条主流的L1/L2,包括 EVM 和非EVM链的所有数据,都被纳入整合到统一的生态中。

其次,这个全链数据,里面到底有什么?

答案是,关于区块链的一切。

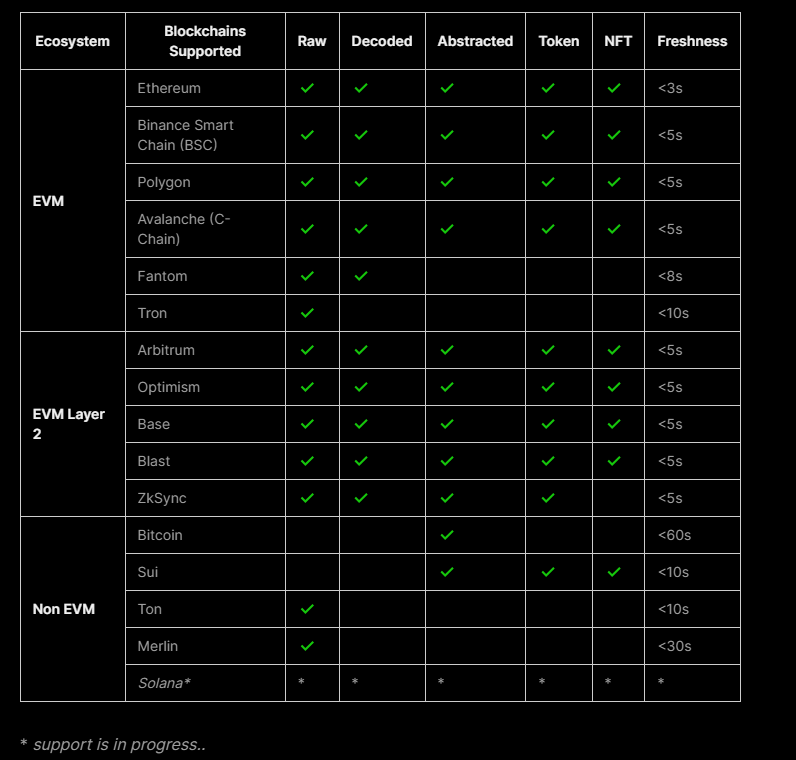

我知道这个答案过于抽象,如果剖开细看,那么你大概会看到这么几种类型的数据:

Raw 数据:最初记录在区块链上的数据,如区块、合约、合约、交易...

Decoded 解码数据:从原始数据中提取数据并转换为人类可读的格式,例如不同DeFi协议的交易情况...

Abstracted 抽象数据:高级数据,提取关键信息和指标,使其更适合业务分析和决策。如代币、价格、铭文&符文等更容易理解或指定需要分析的地方。

这就有点像你想做菜(用数据做分析),那么不同食材从纯生(Raw)到半熟(Abstracted),都可以为你所用。

值得一提的是,Chainbase 数据网络中的这些全链数据还做到了实时提供(刷新间隔小于3秒),意味着不仅食材生熟任君挑选,食材本身也保持新鲜。

而这也是目前大部分加密数据项目无法做到的数据保鲜度。

那么,这么多全链数据从何而来?

对链上数据来说,任意链的 NODE operator 或者 RPC provider,都可以接入Chianbase 网络,通过 Chainbase 产品架构中的公开数据网关(open data gateway)提供不同链的上述数据。

而这也构成了 Chainbase 的数据入口,即 Data Accessibility Layer。考虑到其实现需要一定程度的技术理解,我们会在后文的架构分析中详细描述,在此仅作功能说明。

最后,这个全链数据有多大?

从 Chainbase 官网的公开数据来看,目前网络中已经存储了 PB 级别的数据量,并且每天处理着 1.1亿- 1.5 亿次的全链数据调用,而累计调用总量已经超过了总共 5, 000 亿次。

而这些数据调用的源头,源自于已经合作的 15000 + 开发者和8000+ 的加密项目方。

在我们看不见的加密世界深处,一个庞大的全链数据网络已然形成。

从数据体量看,最大的全链数据名副其实。但背后提供支持的全链"网络"概念体现在哪里?

站在整体视角上,前文所述的 Data Accessibility Layer 首当其冲,吸纳着全链中的一切数据,承担着入口的职责;

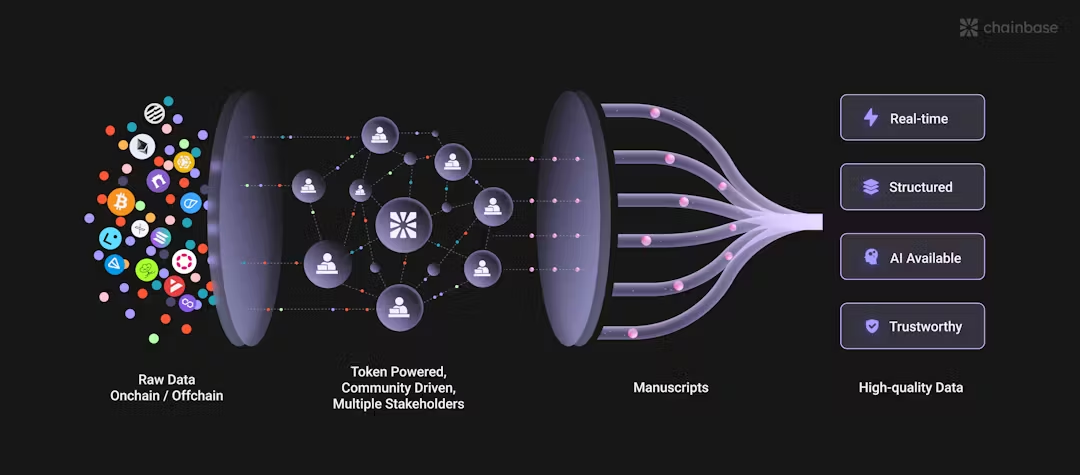

其次,全链数据的处理并非 OpenAI 和云厂商那样的中心化处理,Chainbase 搭建了一个代币激励驱动、社区主导、多方共同参与各司其职的处理结构, 对数据进行加工;

最后,上文所述的链上下原始数据经过处理,为 Chainbase 的数据网络可见,网络中的开发人员可以基于原始数据构建"手稿",用于定义、提取、转换和处理链上数据,从全链数据中提取有价值的信息进行分析。

由此观之,全链数据从幕后到登台,经历了搜集,处理,呈现,利用等多个环节;为数据的利用提供"道"层面的支持,而具体的"术",包括但不限于:

使钱包能够从单一界面管理和查看多个区块链上的资产,提高用户的便利性;

安全领域:跟踪攻击,提供安全警报并进行深入的安全分析以保护区块链网络;

社交领域:构建社交平台,让来自不同区块链的用户可以无缝互动和共享内容;

DeFi: 使 DeFi 平台能够支持跨不同区块链的借贷,增加流动性和灵活性。

注意以上这些仅是示例,作为一个基础设施产品,Chainbase 的好处在于--- 这些应用都能通过它实现,但 Infra 能做的却远不止这些。

4层双共识架构 ,井然有序的舞台之基

全链数据能够在台前起舞,背后必然离不开台后的支撑。

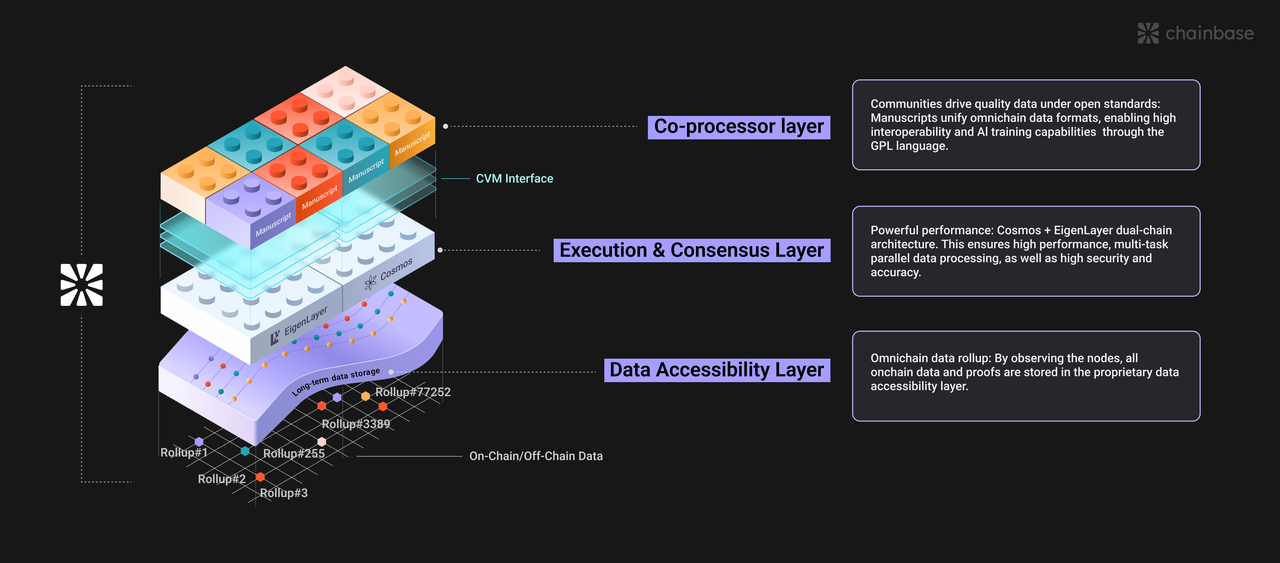

Chainbase 的4层双共识架构数据网络,实际上承担了4根舞台台柱子的工作 --- 每层都有自己的职能,来共同为全链数据的利用搭台唱戏,同时保证一切幕后工作井然有序。

在讲述全链网络时,前文已经粗浅的涉及到了这一架构,接下来让我们以更加详细的视角进行分析。

既然 Chainbase 的一切业务都在围着数据打交道,那么我们不妨以数据的进入、处理和输出这个过程为切入点,自下而上看看这4层架构到底都在干什么:

数据获取层:全链数据的入口,解决数据怎么进入网络的问题。

共识层:数据处理时,当数据状态发生改变,那么去中心化网络需要以某种方式,对数据状态的变化达成共识,这也是大部分加密项目熟悉的"共识老味道"。

执行层:既然数据处理业务能够发生,那么必然需要通过各种方式来保证数据处理被安全且高效的执行。

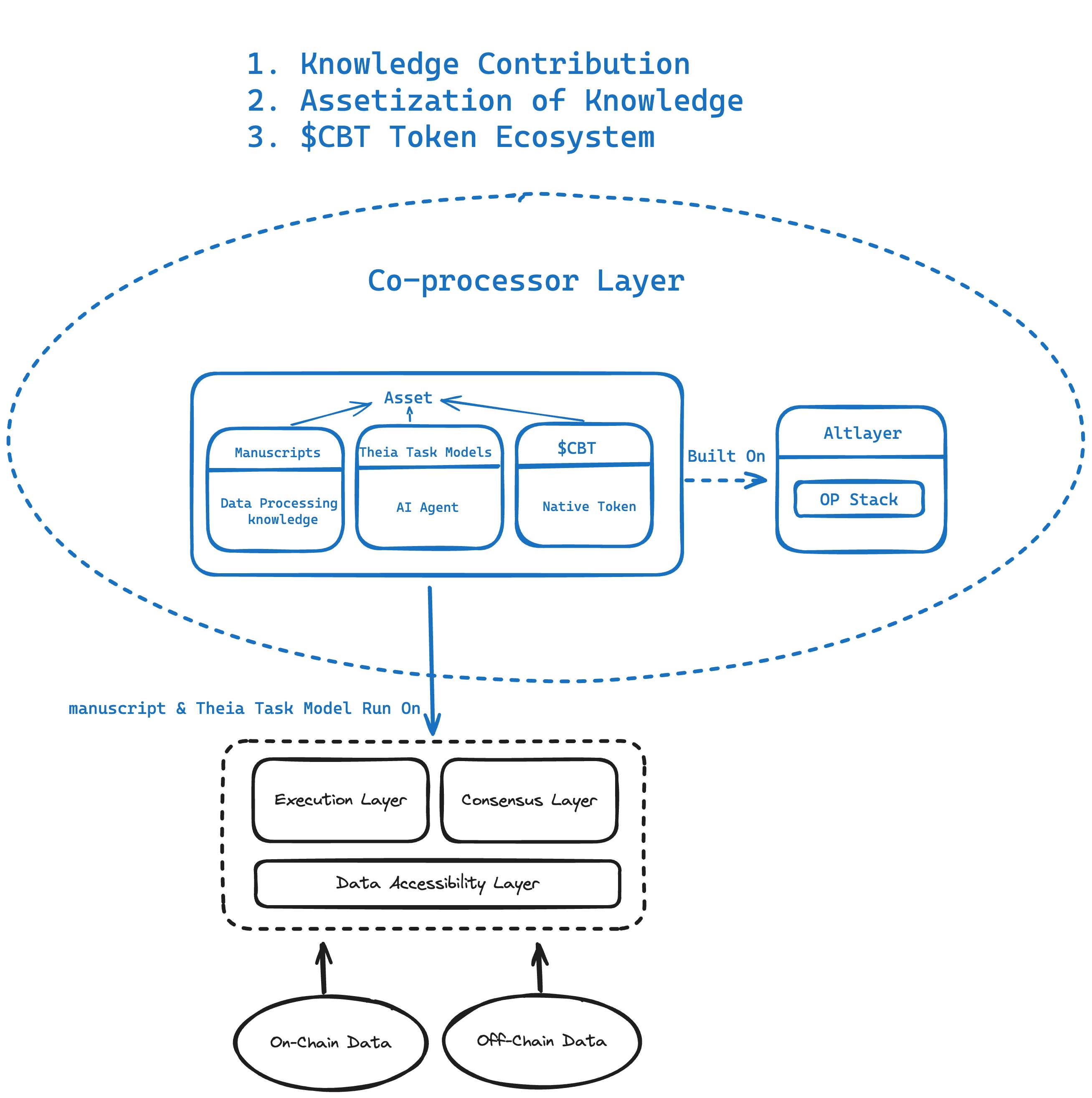

协处理层:你可以通俗理解成数据输出的地方,其中涉及到数据如何输出、输出给谁用,用在什么地方等问题。而其中的协处理,则意味着社区共同协作来生成高质量数据,应用于各种场景。

从以上逻辑出发,你很容易理解数据怎么进来,怎么加工,怎么利用,Chainbase 的4层架构其实就在各司其职。

接下来,我们可以针对这4层做逐层拆解,一览每一层的工作模式和存在价值。

数据获取层:全链数据的Rollup,链下数据的安全集成

该层是Chainbase的数据入口。

对链上数据来说,任意链的 NODE operator 或者 RPC provider,都可以接入Chianbase 网络,通过 Chainbase 产品架构中的公开数据网关(open data gateway)提供不同链的上述数据。

对于链下数据来说,例如社媒用户行为的数据等,同样也可以通过ZK等可信方式,由公开数据网关进入数据获取层,并以 Rollup 的方式接到 Chainbase 网络中来,在保证隐私的同时获取数据。

本质上,这更像一个去中心化的数据湖,起到沉淀数据的作用。同时,ZKP保证传上来的数据是对的但隐私是被保护的;而多节点共同参与数据存储和验证(SCP)的方式,则保证了数据的可靠性与组织方式的去中心化。

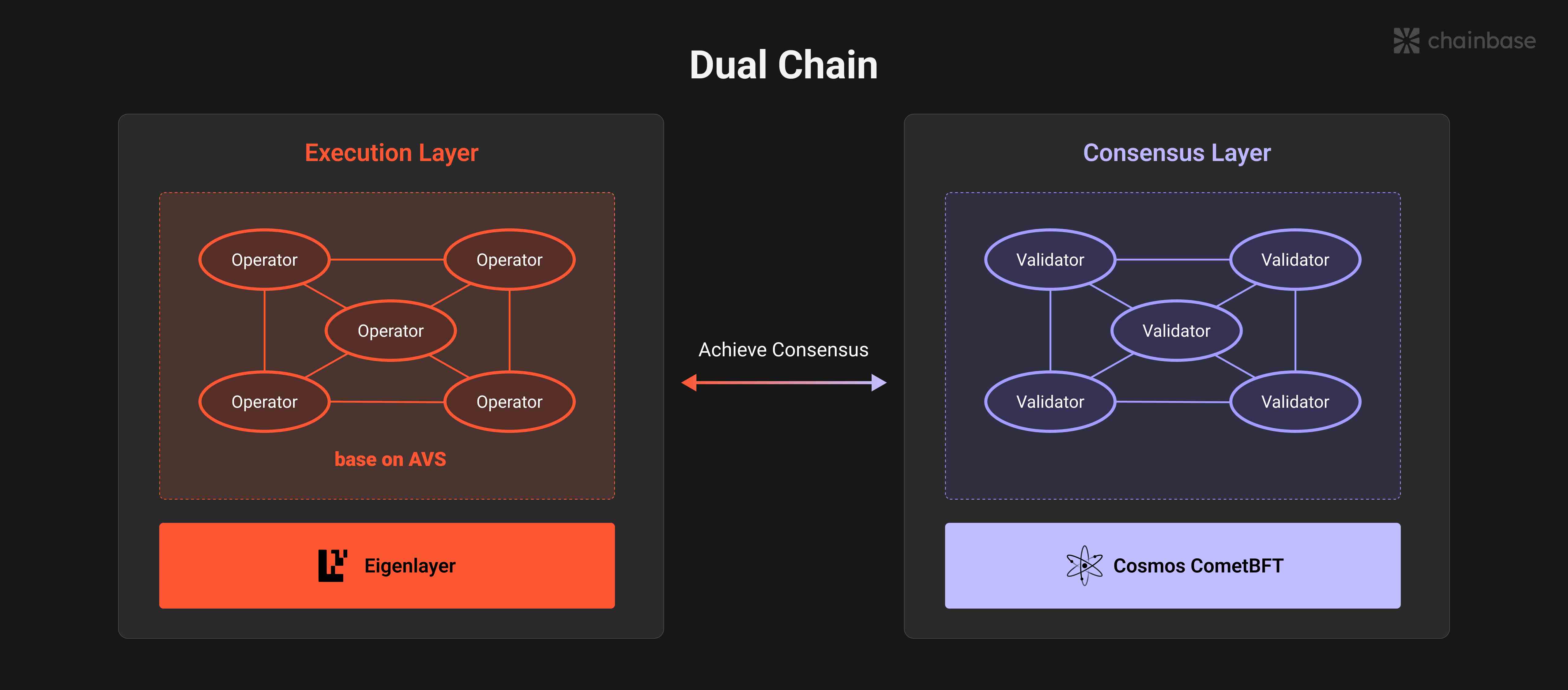

共识层:由Cosmos 提供的 CometBFT 共识机制,保证状态同步

任何一个加密产品其实都面临着一个经典问题:在完全公开且信任有限的环境下,怎么对一件事情的状态变化达成一致?

具体到Chainbase中,这件事情就变成了数据处理状态的变化。

如果要对状态变化达成共识,那么必然少不了区块链的存在和共识算法的使用。Chainbase 采用的是 Cosmos 的 CometBFT 共识算法,在此不做过多的技术科普;

我们只需知道这是一种改良的拜占庭容错算法,至多能够容忍网络中三分之一的节点出现故障或恶意行为,即使部分节点作恶,同样也能够达成共识。

这种宽容阈值兼具效率与弹性,与数据处理这种较大数据负载下高效达成共识的场景适配。

执行层:EigenLayer + 链上数据库,保证性能的同时引入额外的经济安全性

当 Chainbase 网络中有数据调用需求了,执行层就有了用武之地。

任何对数据的操作,其实都需要"场地",即数据库。Chainbase 使用了自家的 Chainbase DB 链上数据库,专门用于支撑数据和任务的并行处理,以面对可能的高并发调用需求,从而保证整个网络的性能和吞吐量。

但数据能够被执行,并不意味着它被执行的足够安全。

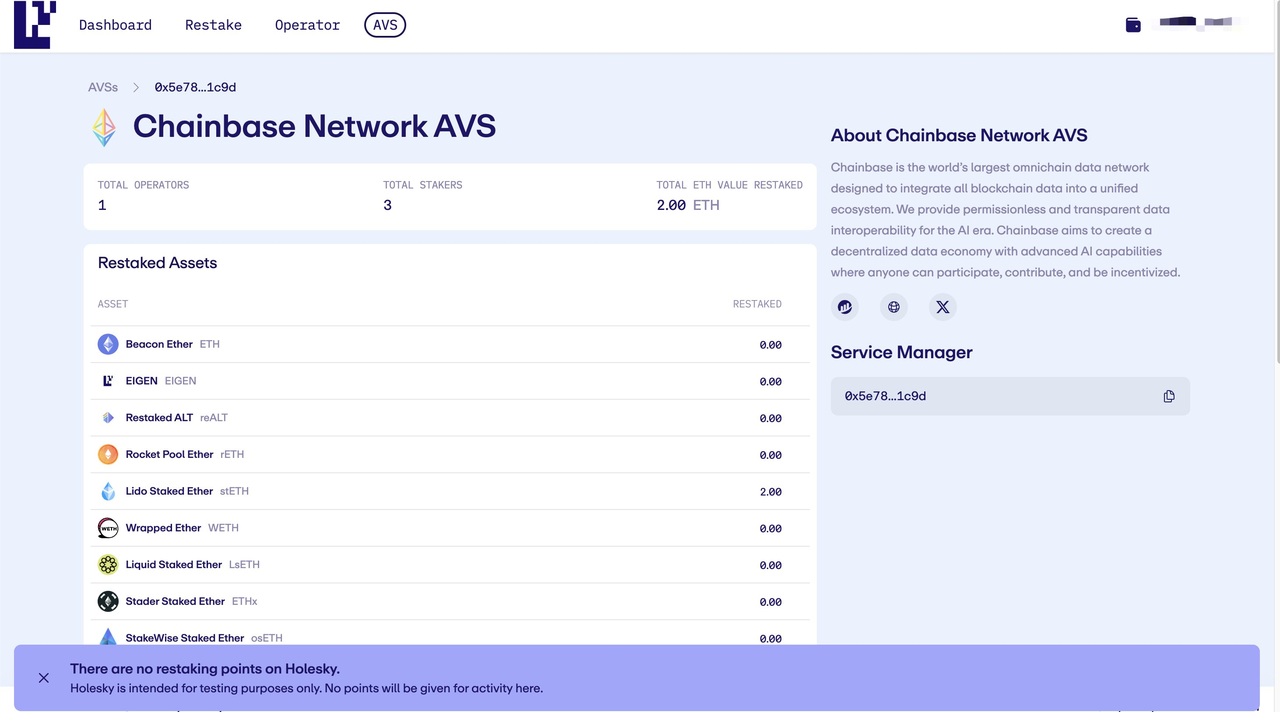

因此,Chainbase 的解决思路,是从 EigenLayer 那里获得经济安全性。

利用 EigenLayer 继承的特性,Chainbase 构建了自己的主动验证服务(AVS);这种做法可以使得 Chainbase 获得 ETH 质押者从以太坊继承的强大经济安全性,来保证自家数据处理服务的安全。

协处理层:社区共建,多个参与者各司其职,将数据价值最大化输出

这一层离我们的直觉最近,能够看见数据是如何被利用以发挥价值的。

在加密世界中,不同应用场景会产生大量多样的数据,·如何从这些孤立而多样的数据中提取价值是协处理层需要解决的问题。

Chainbase 这层设计的主要思路是,让大量开发者进行协作,积累知识,从而产生集体智慧。

而这种协作,落到具体的功能上是:

知识贡献:用户可以将他们在数据处理和专业任务模型方面的专业知识贡献给协处理器层。这种协作环境利用集体智慧来增强网络的功能。

知识资产化:协处理器层将知识的贡献转化为资产,管理这些资产的分配、流通和交易,确保贡献者的知识和努力得到回报。

CBT代币生态系统:网络激励结构不可或缺的一部分,促进支付、结算、质押和治理,后文会进行详述。

如果通俗来说,协处理层可以实现的效果是,比如我需要一份"分析链上钓鱼骗局"的菜谱,开发者们则会针对性的提取这一需求需要哪些数据,组合打包成模板,供大家使用。

最后,Chainbase 网络也有普通用户参与的空间。

一般的加密玩家们可能并不具备什么数据分析知识,但他们仍然可以以自然语言的方式与Chainbase网络进行交互,获得各种关于加密世界的洞见和情报;

直观来看,这更像一种加密版的ChatGPT,但并不是套皮界面后直接用了GPT的内核;相反,Chainbase 在协处理这一层,面向普通用户则给了一个更大的杀招:

Theia,用海量全链数据,训练的一个加密原生的AI大语言模型。

Chainbase 在处理数据业务的同时,利用70亿通用大语言模型参数+2亿 crypto 参数训练出了Theia。

注意,加密原生的意思是指,在 GPT 鞭长莫及的加密世界里去塑造一个能够实时感知的智能体,理解加密世界时时刻刻正在发生什么。

套皮 GPT 虽然也能用,但并不能理解原生的、加密的上下文语境,也不能从它那里获得实时、低延迟的加密原生内容。

当前大部分链上数据的AI使用方式,是把schema喂给AI之后帮助写SQL 语句查链上数据,仍只停留在非智能的查询阶段,从数据库中捞数据的阶段,本质上仍是索引模式的Plus版本。

而 Theia 的工作模式,本质上是智能模式 --- 基于已有的海量链上下数据,做更加高效的思考、分析与回答,具备主动性、创造性和实时性,与目前的链上数据产品不在一个维度。

于是,一个更适合加密人群体质的大语言模型出现了。

日后,信息优势可能不再是币圈"科学家"的专利,Theia 将AI的智能能力解锁到了更大的范围群体,普通人也可以通过AI模型来使用原本专业和硬核的全链数据网络。

通过将加密原生的大语言模型Theia 链接到外部资源(RAG), 使生成式AI 输出更准确的回答。

用户仅需要与友好的问答式界面交互,即可得到更加智能化的回应,而这些回应基于从广泛的链上和链下数据以及时空活动中学习加密模式,以及对加密模式的因果推理。

例如,当你只是随意询问“最近热门的DeFi协议是啥?”的时候, 如何定义热门,如何用数据佐证热门,对这些热门协议的排序和呈现... 都由 Theia 替你完成,并给你一个最后的综合结果。

而数据科学家也能利用 Theia 构建任务模型,授人以渔,例如:

安全任务模型--专面向安全领域,比如让AI评估加密安全漏洞,实时威胁监控以及合规性审计

交易任务模型--如分析市场趋势、策略优化和风险管理

意见任务模型--追踪社媒情绪、热点趋势和事件影响力等等

在AI能力这件事上,授人以鱼始终不如授人以渔。

从目前的公开信息来看,Theia 能做市面上所有加密AI产品能做的事,底气和实力来源于海量数据及模型调优;这更像授人以渔的做法,而不是面向具体场景给一条单独的鱼。

同时,通过协处理这层也能看到,全链数据们联袂演出,让加密原生模型 Theia 跳起了智能之舞。加密世界获取信息、情报和见解的方式或将被颠覆和革新,AI也在帮助加密变得更好。

层中的双共识:效率与安全并重,兼顾经济权益

在了解了 Chainbase 的4层架构之后,再看其中的双链,就变得非常好理解了。

由于引入了 Cosmos 和 EigenLayer,使得围绕数据处理本身和处理状态变化这两件事,有了更多的保障。

EigenLayer 在执行层中起作用,AVS承担执行任务,继承以太坊的经济安全性;Cosmos 在共识层起作用,优化的BFT算法对数据处理的状态变化达成一致,且保证一定程度的容错。

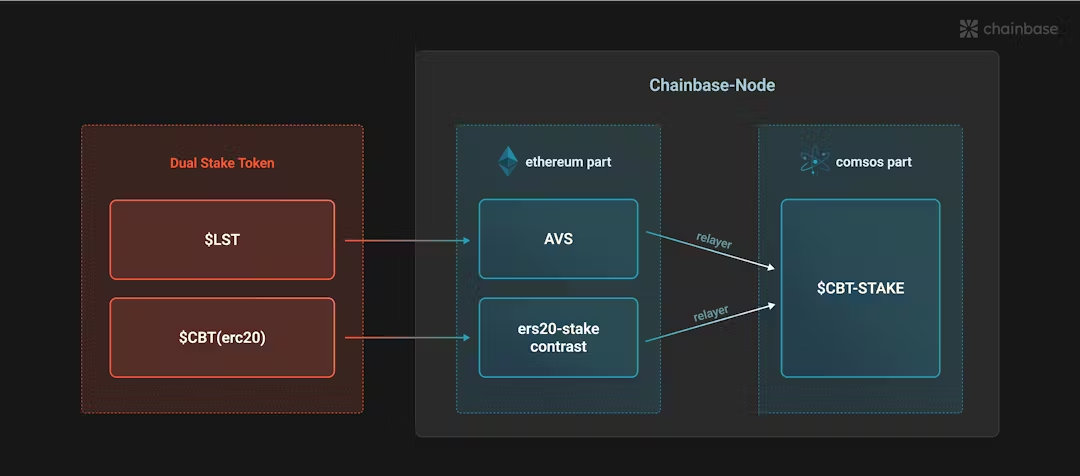

更为重要的是,双共识的引入自然也带来了经济上的双币质押机制,缓解传统POS网络的死亡螺旋问题:

一般情况下,当某个项目单币的价值开始下降时,如果项目采用POS的设计,那么整个网络的安全性也会降低,质押代表的TVL减小;同时基本面恶化又会进一步压低代币价格,造成恶性循环,使得项目安全不断萎缩。

而在双共识设计下,Chainbase 既有项目自己的CBT代币用于质押,也有以太坊生态的各类LST代币可以质押,增加网络经济安全性的同时,盘活 LST 资产的价值,吸纳更多项目外的流动性进入。

不过既然谈到了项目代币CBT,虽然官方暂未公布具体的TGE时间和代币经济学,但整个代币的效用和功能是清晰可见的,也可以为我们的投研提供参考。

一言以蔽之,CBT 其实是通过经济激励,保证网络参与者各司其职的关键。

Chainbase网络运营节点,确保数据处理任务的顺利进行,获得80%的数据查询费用(用户使用Chainbase网络利用数据,需支付费用)+ 运营商池100%的奖励(由chainbase项目设立);

验证者验证交易、确保数据完整性并维护网络稳定性,获得100%的区块奖励;

开发人员/数据科学家:编写手稿确保数据集能够被有效地处理和查询,提供更好的数据处理逻辑,获得15%数据查询费用奖励

委托者:将代币质押给验证者和运营商来分享奖励,类似以太坊的委托质押协议中的收入

综合来看,Chainbase 的这套4层双共识架构,是整个数据网络的核心,让数据处理的整个过程顺畅、高效的完成,也兼顾了经济效益和安全性。

一种精妙、自洽且清晰的安排,为全链数据登台演出的打下牢固的地基。尤其是协处理层孕育加密原生AI模型的举措,也让整个数据的利用上了一个新的台阶和广度。

从数据到智慧提供,加密与 AI 互相成就

在研究完 Chainbase 的产品后,笔者觉得它正在进行一种角色转换,即从纯的数据提供者,转变为支持AI的全链数据网络。

这种角色的转换,并不是单纯换了个空泛的叙事,而是意味着它在如何利用加密世界的数据这件事上,迈出了更加坚定的一步。

从产品上你能明显感觉到确实不仅仅在提供数据,更是为数据的智能化利用,为形成智慧创造更好的条件。

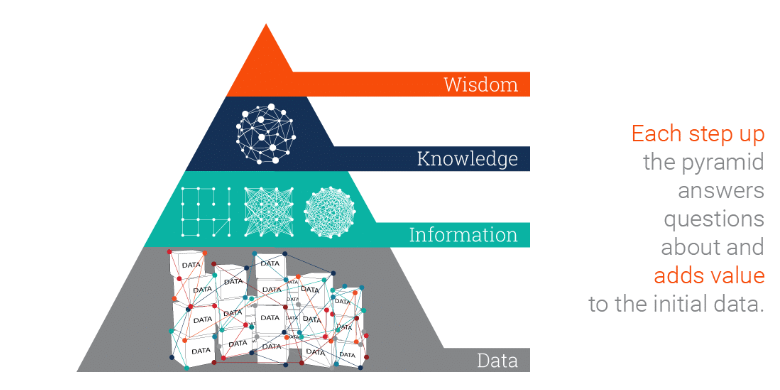

在知识管理领域,有一个经典的 DIKW 模型如下图,用来表示知识获取的层级与方式;而这也不禁让我们对整个加密行业关于数据和信息的利用,产生了更加深入的思考:

从这个模型出发,当前的多数加密项目,最多只是在提供数据和信息,远未形成知识和智慧;

而主动性和创造性,才是链上数据利用的终局;AGI 时代 GPT4 已经在提供知识与智慧,加密世界的数据利用仍旧任重道远。

从数据 -- 信息--知识--智能,加密数据可以让AI变得更好,反过来AI能力为加密业务提供更多智慧和洞见,提升加密业务的效率和体验。

Crypto 和 AI,或许本就应当相互成就。

对 Chainbase 本身而言,笔者也有着更多的期许。

当前项目确实也已经有了足够的数据量,Theia 模型也初见端倪,同时官推显示测试网进度50%,正式产品可以期待在今年内发布;

全链数据的威力,正在等待着进一步的释放,Chainbase 或许会给加密世界带来经济学意义上的“帕累托改善”:

加密全局迎来效率提升,而不会以牺牲某些局部的利益为代价。

在一轮加密数据利用的新范式下,没有人会是输家。