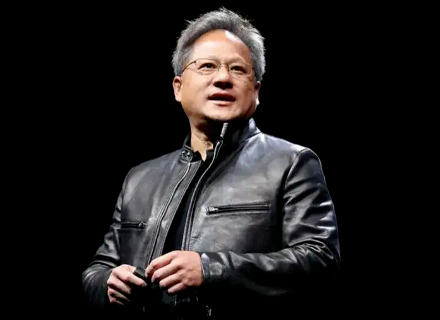

对话实录:黄仁勋对话Transformer论文七大作者,探讨大模型未来

2017年,《Attention is All You Need》论文提出了基于自注意力机制的Transformer模型,通过并行处理的注意力机制解决了长距离依赖问题,大大提升了序列数据处理速度。这一创新架构在人工智能领域掀起了风暴,使得机器翻译、语音识别和文本摘要等任务更加高效和精确。Transformer模型的出现得益于八位曾在谷歌工作的AI科学家的共同努力,他们也表达了对未来发展的期待,希望能有更好的模型取代Transformer,实现更高的性能。该文讨论了人工智能模型的推理问题,以及一些创始人的想法和公司的发展方向。